Konferencja na temat sonifikacji danych związanych ze zdrowiem i środowiskiem została ufundowana przez Wellcome Trust oraz Centre for Chronic Diseases and Disorders (C2D2) na University of York. Zorganizował ją Wydział Teatru, Filmu i Telewizji oraz Sztokholmski Instytut Ochrony Środowiska przy Uniwersytecie w Yorku.

Konferencja zebrała ekspertów w dziedzinie sonifikacji, projektowania dźwięku, naukowców związanych ze zdrowiem i ochroną środowiska, aby przeanalizować i przedyskutować podejścia do pracy z dźwiękiem i danymi.

Sonifikacja polega na przedstawieniu danych w formie dźwięków, tak by słuchacze (eksperci i/lub laicy) mogli dostrzec oraz zapoznać się ze strukturami, właściwościami danych oraz ich znaczeniem.

Dźwięk może być bardzo efektywnym sposobem prezentacji i eksploracji dużych baz danych (big data), monitorowania procesów oraz przedstawiania skomplikowanych informacji w kreatywny oraz absorbujący sposób. Dźwięk, zawsze oparty na linii czasu, jest szczególnie dobry do reprezentowania danych opartych na czasie (np. ewolucja fenomenu środowiskowego w czasie), jak również prezentacji danych w czasie rzeczywistym (np. ruch mięśni może być przełożony na słuchowe sprzężenie zwrotne).

Dźwięk może ostrzegać słuchacza przed anomaliami i zdarzeniami, kiedy wzrok jest zajęty inną czynnością, a duże ilości danych mogą być przekazywane natychmiastowo w pojedynczych lub rytmicznych seriach dźwięku o konkretnej barwie.

Dodatkowo, dźwięk może pomóc w przedstawieniu korelacji i połączeń pomiędzy różnymi zestawami danych, co jest bardzo pożądanego w przypadkach, kiedy dane na temat zdrowia są mocno połączone z danymi środowiska.

Konferencja składała się z kilku paneli oraz instalacji audio, których zakończeniem był występ projektu Space F!ght prezentujący sonifikację danych NASA związanych z ozonem w dolnych partiach atmosfery. Dane zmappowane w patchu Max/MSP podawały natężenie w woltach do syntezatora modularnego Eurorack, który przetwarzał je na żywo w dźwięki.

Muzycy obecni na sali dogrywali się odpowiednio w zależności od poziomu ozonu, przedstawionego zarówno dźwiękiem jak i wizualizacjami.

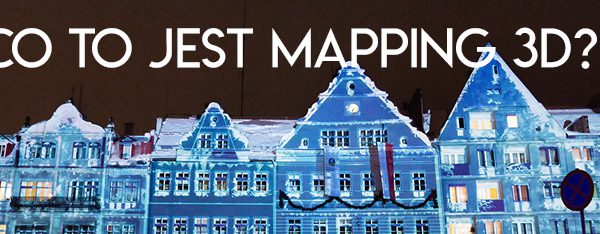

Ja otrzymywałem kolejno sygnał midi zmieniający twarde dane w tabelach VVVV, całość tworzyła show, w którym dane były zarówno słyszalne jak i widoczne na naszej piramidzie w formie video mappingu.

- SoniHead, York 2014